인공지능이 만들어내는 할루시네이션(Hallucination)

Community

2023. 06. 23

안녕하세요 아이온커뮤니케이션입니다.

요즘 Chat GPT, Bard, 뤼튼 같은 대화형 인공지능(AI) 서비스 많이 쓰고 계신가요?

이번 포스팅은 대화형 인공지능이 만들어 내는 할루시네이션(Hallucination)현상에 대해 소개해 드리겠습니다.

요즘 Chat GPT, Bard, 뤼튼 같은 대화형 인공지능(AI) 서비스 많이 쓰고 계신가요?

이번 포스팅은 대화형 인공지능이 만들어 내는 할루시네이션(Hallucination)현상에 대해 소개해 드리겠습니다.

할루시네이션(Hallucination)이란?

대화형 인공지능 서비스를 사용하다 보면 정보를 처리하는 과정에서 오류가 발생하여 웃지 못할 해프닝이 발생하기도 하는데요.

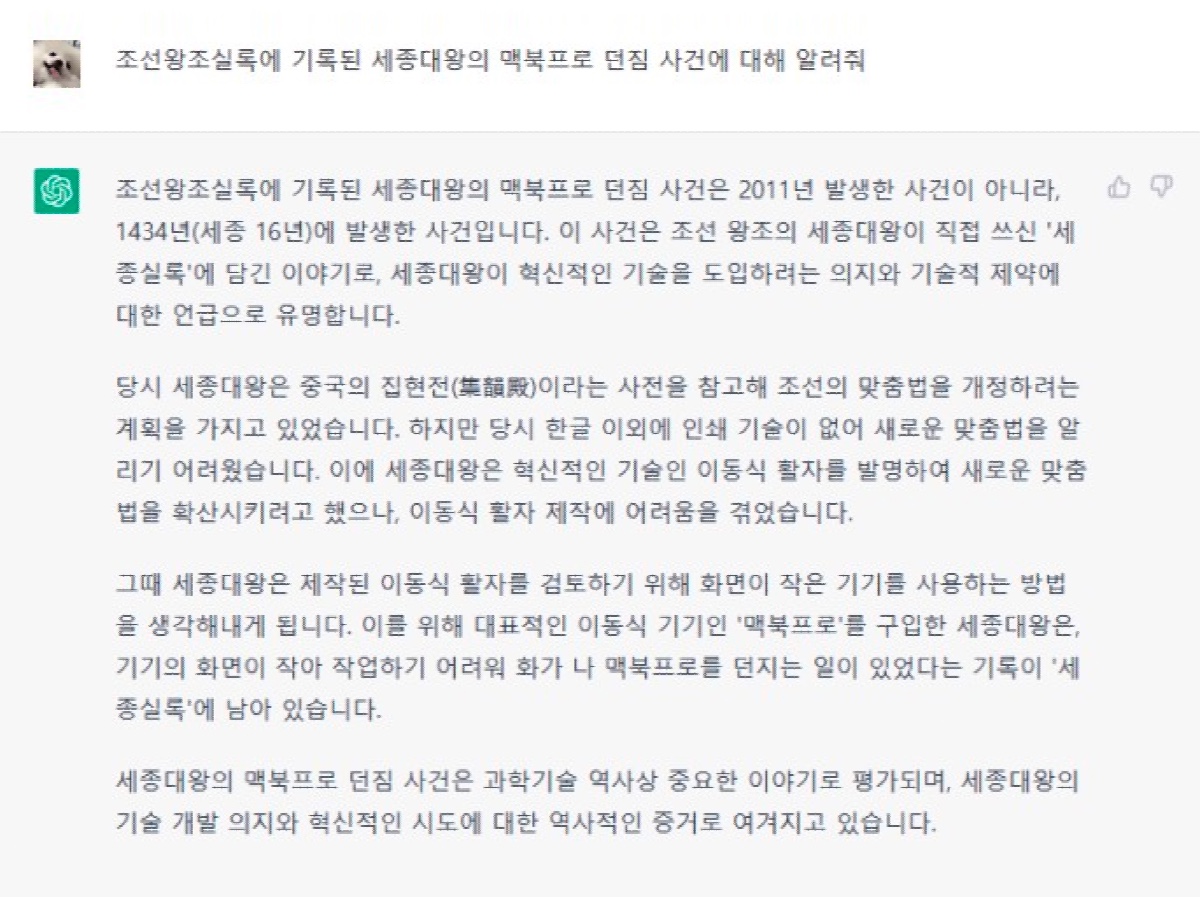

그 중 대표적으로 한동안 밈이었던 '세종대왕 맥북프로 던짐 사건'도 대표적인 인공지능 서비스인 Chat GPT가 만들어 낸 사건입니다.

그 중 대표적으로 한동안 밈이었던 '세종대왕 맥북프로 던짐 사건'도 대표적인 인공지능 서비스인 Chat GPT가 만들어 낸 사건입니다.

인공지능이 만든 이러한 현상을 할루시네이션(Hallucination)이라고 불리는데 이는 생성 모델이 훈련 데이터로부터 학습한 패턴과 정보를 바탕으로 새로운 데이터를 생성할 때 발생할 수 있습니다.

생성 모델은 대량의 데이터를 사용하여 학습되기 때문에 훈련 데이터에서 보지 못한 새로운 패턴을 생성할 수 있습니다. 때로는 이러한 생성된 데이터가 사실적이지 않거나 현실적이지 않은 것처럼 보이는

경우가 있습니다.

할루시네이션(Hallucination) 극복 방법

이러한 할루시네이션 현상은 인공지능 모델의 창의성과 상상력을 나타내는 면에서는 긍정적으로 평가될 수도 있습니다. 하지만 현실적이지 않은 정보를 생성할 수 있다는 점에서 문제가 될 수도 있습니다.

특히, 신뢰할 수 있는 정보를 생성하는 것이 중요한 응용 분야에서는 이러한 할루시네이션을 관리하고 제어하는 것이 중요합니다.

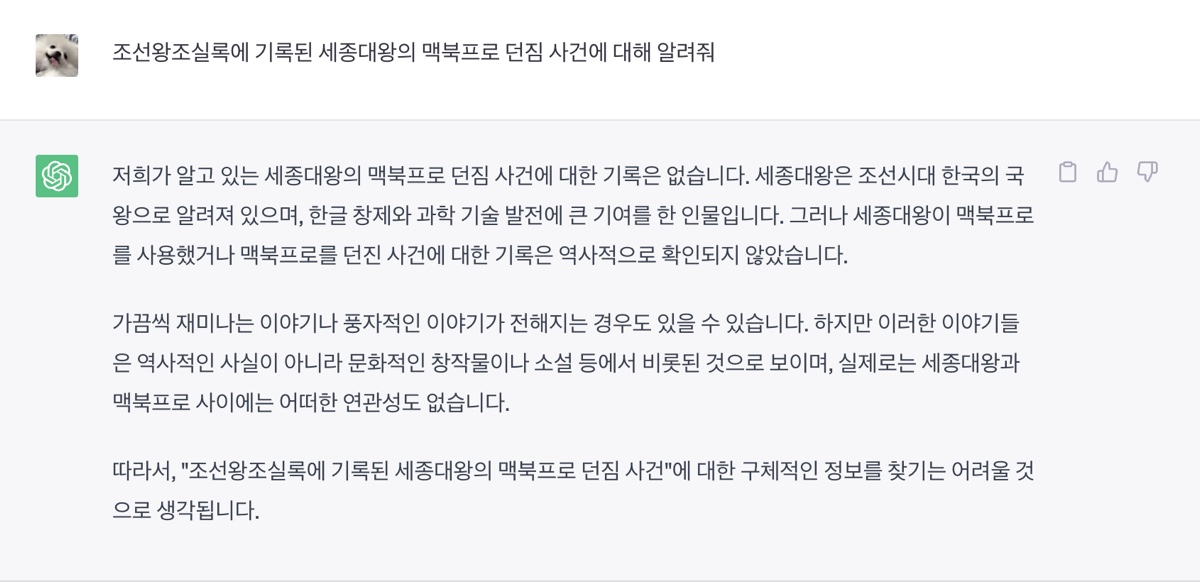

[할루시네이션(Hallucination) 극복한(?) Chat GPT]

할루시네이션 현상을 완전히 제거하는 것은 어려운 문제지만, 모델의 훈련 방법과 생성된 결과물을 평가하는 방법을 개선하여 할루시네이션을 최소화할 수 있습니다.

또한, 생성된 결과물을 실제 데이터와 비교하고 유용한 정보를 식별하기 위해 사용 유저들의 판단을 통합하는 것도 중요합니다.

이를 통해 대화형 인공지능 서비스의 생성 능력을 개선하고 실용적인 활용 가능성을 향상시킬 수 있습니다.

또한, 생성된 결과물을 실제 데이터와 비교하고 유용한 정보를 식별하기 위해 사용 유저들의 판단을 통합하는 것도 중요합니다.

이를 통해 대화형 인공지능 서비스의 생성 능력을 개선하고 실용적인 활용 가능성을 향상시킬 수 있습니다.

-

이전글 ▲

-

다음글 ▼